Python爬虫速成指南:从零掌握网络数据采集核心技能

爬虫Python入门

在互联网信息爆炸式增长的今天,掌握网络爬虫技术成为许多人提升职场竞争力的关键。Python以其简洁的语法和强大的第三库生态,成为入门爬虫开发的首选语言。本文将从技术原理、开发环境搭建、核心基础到实践技巧,为初学者提供完整的入门指南。

一、爬虫技术原理

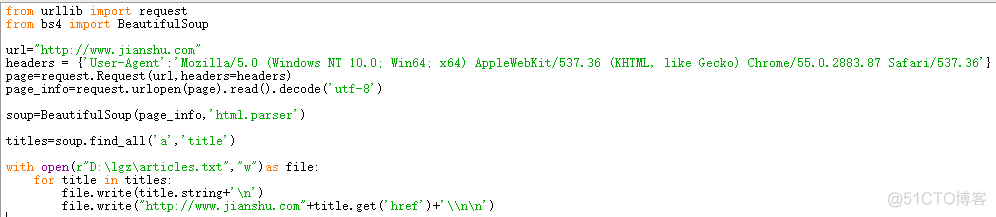

网络爬虫本质上是模拟浏览器行为,通过HTTP协议向目标服务器发送请求,获取网页HTML文本内容,再通过解析技术提取有效数据。这个过程涉及三个核心环节:网络请求、数据解析与存储。Python标准库中的urllib提供了基础的网络通信功能,而第三方库requests则通过更友好的API封装,极大降低了开发门槛。数据解析方面,BeautifulSoup通过CSS选择器实现精准定位,lxml库的XPath语法则擅长处理复杂文档结构。

二、开发环境准备

1. Python安装与配置

建议初学者选择3.8以上版本,在Python官网下载安装包时记得勾选"Add Python to PATH"。安装完成后,通过命令行验证:

python --version2. 虚拟环境管理

使用venv模块创建隔离环境,避免依赖冲突:

python -m venv crawler_env

source crawler_env/bin/activate # Linux/macOS

crawler_env\Scripts\activate # Windows3. 核心库安装

推荐使用pip安装开发所需库:

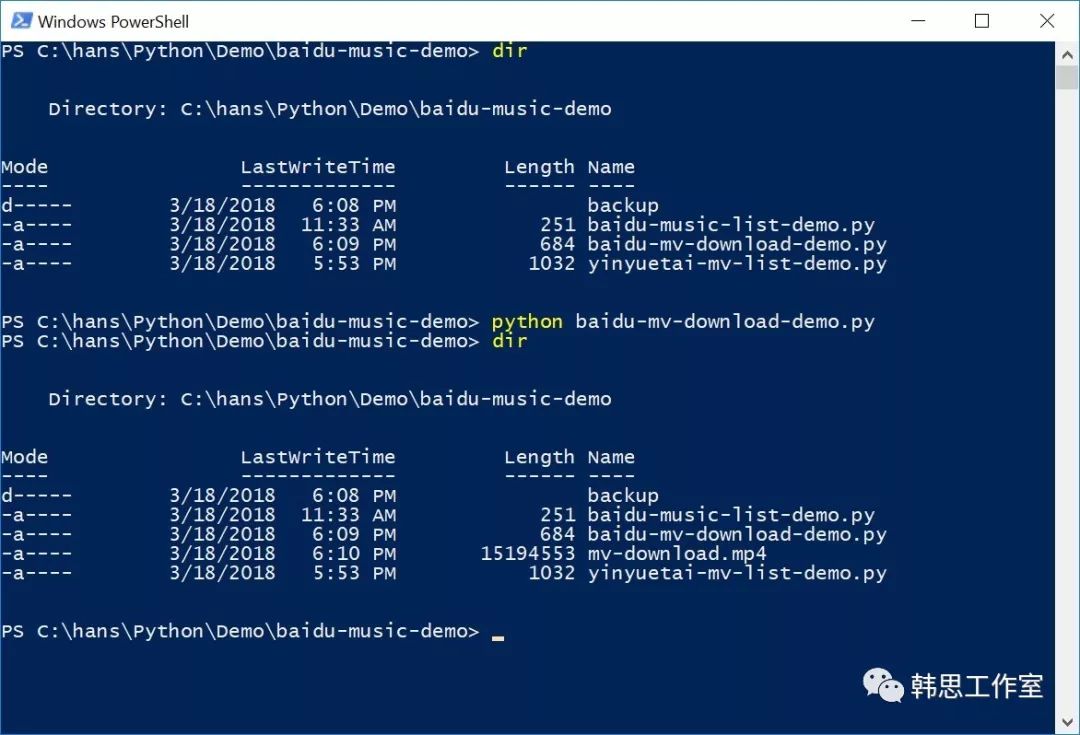

pip install requests beautifulsoup4 lxml pandas三、基础爬取流程

1. 发送网络请求

import requests

url = "https://example.com"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36"

}

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status() # 检查请求是否成功2. 数据解析处理

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, "lxml")

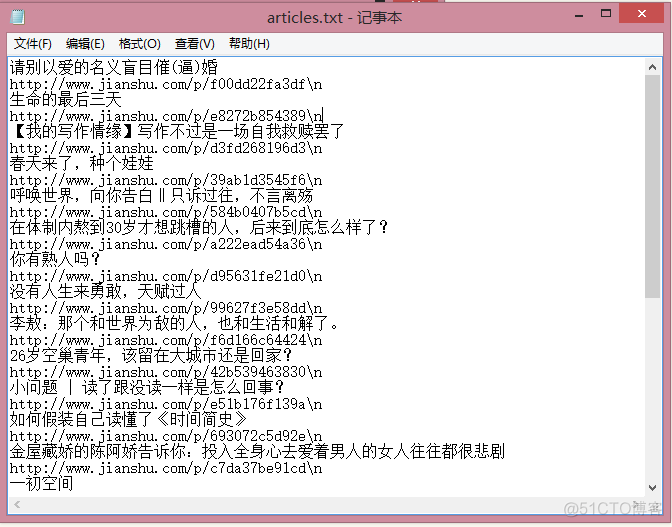

titles = [h2.get_text().strip() for h2 in soup.find_all("h2")]3. 数据存储方案

简单场景可使用CSV存储:

import pandas as pd

df = pd.DataFrame(data={"titles": titles})

df.to_csv("output.csv", index=False, encoding="utf-8-sig")四、进阶实践技巧

-

反爬策略应对:

- 随机User-Agent:使用

fake_useragent库 - IP代理池:配合

scrapy-rotating-proxies中间件 - 请求频率控制:

time.sleep(random.uniform(1,3))

- 随机User-Agent:使用

-

动态页面处理: 对于JavaScript渲染的页面,可使用

selenium或playwright:from selenium import webdriver driver = webdriver.Chrome() driver.get("https://dynamic.example.com") html = driver.page_source -

API数据获取: 分析浏览器开发者工具中的Network请求,直接获取JSON数据:

api_url = "https://api.example.com/data" params = {"page": 1, "limit": 20} api_response = requests.get(api_url, params=params).json()

五、法律与道德规范

在开发实践中必须遵守《网络安全法》和《数据安全法》,特别注意:

- 严格遵循

robots.txt协议 - 控制爬取频率(建议不超过1次/秒)

- 避免获取用户隐私信息

- 数据使用前进行脱敏处理

六、学习路径建议

-

基础阶段(1-2周):

- 掌握requests+BeautifulSoup组合

- 完成5个以上静息页面爬取

- 学会使用开发者工具分析请求

-

进阶阶段(1个月):

- 学习Scrapy框架开发

- 掌握分布式爬取技术

- 实现自动登录、验证码识别

-

部署阶段:

- 使用Scrapyd或Airflow部署任务

- 配置MySQL/MongoDB存储方案

- 学习Docker容器化部署

网络爬虫是连接数据获取与数据分析的重要桥梁,掌握这项技能不仅能提升技术竞争力,更能为后续的数据挖掘、商业分析奠定基础。建议初学者从仿写优秀项目开始,逐步构建自己的爬虫知识体系。记住,优秀的爬虫工程师不仅是技术专家,更是具备法律意识和伦理素养的数字公民。