Python爬虫入门:解锁网络数据抓取新技能

爬虫Python入门

在如今信息爆炸的时代,海量的数据隐藏着无尽的价值与机会。而网络爬虫,正是帮助我们高效地从互联网上抓取所需数据的强大工具。用Python编写网络爬虫,因其语法简洁、功能强大且拥有丰富的第三方库支持,逐渐成为广大程序员和数据爱好者的首选。

为什么选择Python进行爬虫开发?

Python之所以在爬虫开发领域备受欢迎,主要归因于以下几个方面:

-

简洁易读的语法:Python的代码设计理念强调可读性,使得编写和维护爬虫程序变得更加轻松。

-

强大的第三方库支持:如

requests库用于发送HTTP请求,BeautifulSoup和lxml库则用于解析HTML和XML文档,Scrapy框架更是一个功能全面的爬虫框架,能够大大提高开发效率。 -

活跃的社区支持:Python社区活跃度高,遇到问题时,你很容易在Stack Overflow等平台上找到解决方案。

爬虫的基本步骤

编写一个基本的网络爬虫,通常需要经历以下几个步骤:

-

发送HTTP请求:使用

requests库向目标URL发送请求,获取网页的源代码。 -

解析网页内容:利用

BeautifulSoup或lxml解析获取到的HTML文档,提取需要的数据。 -

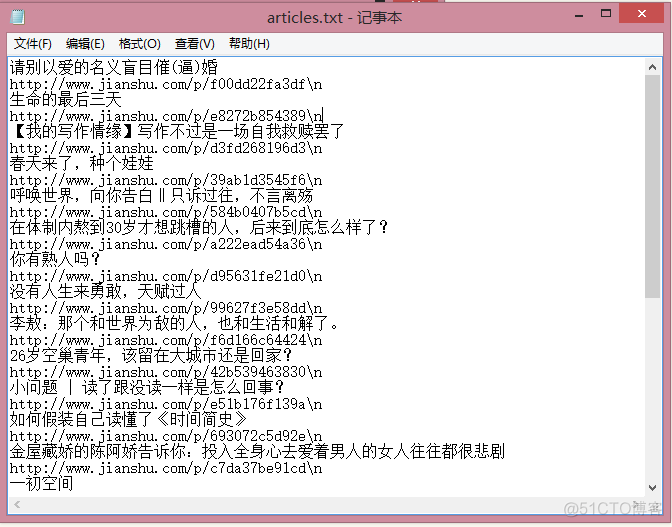

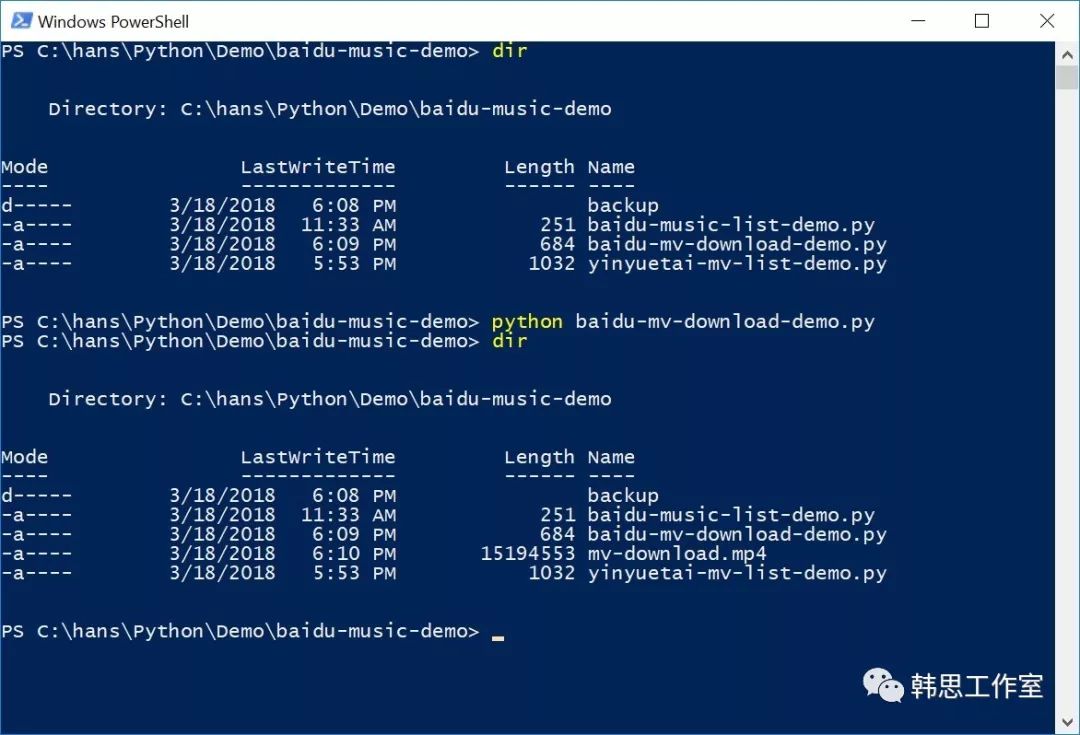

存储数据:将提取到的数据保存至文件(如CSV、JSON)或数据库中。

-

异常处理与反爬机制应对:合理处理请求过程中可能出现的异常,如网络问题、服务器拒绝访问等。同时,了解并应对网站可能采取的反爬措施,如验证码、IP封禁等。

一个简单的爬虫示例

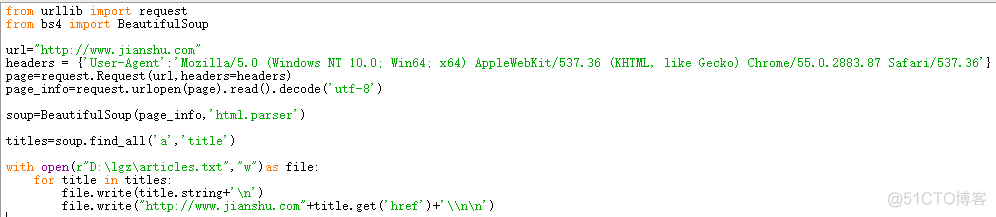

以下是一个使用requests和BeautifulSoup库从网页抓取数据的基础示例:

import requests

from bs4 import BeautifulSoup

# 发送请求

response = requests.get('https://example.com')

# 确保请求成功

if response.status_code == 200:

html_content = response.text

# 解析HTML

soup = BeautifulSoup(html_content, 'html.parser')

# 查找并提取数据

title = soup.title.text

print('网页标题:', title)

# 可以继续提取其他感兴趣的数据...

else:

print('请求失败,状态码:', response.status_code)注意事项

在开始爬虫之旅时,除了技术层面的问题,还需注意以下几点:

-

遵守robots.txt协议:大多数网站会通过robots.txt文件声明哪些内容允许或禁止被爬取。

-

尊重知识产权和隐私政策:确保你的爬虫行为合法,不侵犯他人的权益。

-

合理设置请求频率:过多的请求可能会给目标网站造成负担,适当设置延迟或使用代理IP池以避免被封禁。

总之,Python为网络爬虫的开发提供了一个便捷且强大的平台。随着实践的深入,你会不断发现更多高级技巧和最佳实践,让你的爬虫更加灵活、高效和稳健。